68666

•

16 minutes de lecture

•

Les pénalités de Google sont extrêmement désagréables pour les propriétaires de sites Web, en particulier ceux qui dépendent de la recherche organique pour générer des revenus. Ce guide résume toutes les principales raisons des pénalités algorithmiques et manuelles de Google, donne des conseils de récupération et des mesures de prévention.

Une pénalité Google est un impact négatif sur le classement d'un site Web dans les résultats de recherche en raison d'une violation des consignes de Google pour les webmasters. Cela peut résulter de mises à jour algorithmiques ou d'actions manuelles pour des problèmes tels que du contenu indésirable, du bourrage de mots clés ou des backlinks artificiels. Les pénalités réduisent la visibilité du site dans les résultats de recherche, ce qui a un impact sur le trafic et les performances.

Les pénalités de Google peuvent être classées selon les types suivants:

En fonction de l'ampleur de l'impact, les pénalités de Google sont divisées en:

Google surveille la qualité des recherches à l'aide d'algorithmes et d'évaluateurs humains. En outre, il existe un outil permettant à chacun de signaler des contenus malveillants, du phishing, des liens payants ou du contenu de spam.

Si vous faites du référencement black hat ou gray hat et que vous recevez une pénalité, il est urgent de régler le problème. Même si seule une partie de vos pages est affectée, l'autorité globale du domaine diminuera et il aura du mal à se classer pour le reste des requêtes.

Cependant, même après avoir supprimé le contenu ou les liens qui ont conduit à une sanction de Google, cela ne garantit pas que tous vos classements seront rétablis au niveau d'avant la sanction. Mieux vaut donc prévenir que guérir: découvrez pourquoi des sanctions de Google peuvent survenir et évitez-les.

La récupération des pénalités Google est le processus de restauration de la visibilité et du trafic de votre site Web dans les moteurs de recherche après une pénalité de Google. Cela implique d'identifier la cause (contenu de mauvaise qualité, backlinks indésirables ou problèmes techniques) et de prendre des mesures correctives telles que le désaveu des liens nuisibles, l'amélioration de la qualité du contenu et le respect des directives de Google pour regagner le classement et la couverture de l'index.

Détecter les pénalités manuelles est très simple: cochez la case Actions manuelles dans Google Search Console. Sur un site Web en bonne santé, vous verrez un message indiquant que tout va bien. Pour savoir si des pénalités ont été émises dans le passé, vous pouvez consulter les messages sous l'icône en forme de cloche dans le coin supérieur droit.

Pas de chance, et vous verrez l'avis pénal rouge indiquant les problèmes qui ont été détectés.

Comme c'est souvent le cas avec les actions manuelles, les référenceurs savent à qui imputer la faute. Le problème peut survenir à cause de liens payants, de bourrage de mots-clés, de contenu généré automatiquement, c'est-à-dire de tout ce qui a été ajouté aux pages dans le but de manipuler les classements.

Pour détecter les pénalités partielles ou algorithmiques (pour lesquelles aucune notification n'est émise), vous devez observer régulièrement les classements. Voyons comment mettre en place un suivi régulier pour observer les anomalies dans Rank Tracker (notez que vous aurez besoin d'une licence Professional ou Enterprise).

Étape 1. Lancez l'outil et ajoutez l'URL de votre site pour créer un projet.

Étape 2. Ajoutez vos mots clés cibles au suivi du classement et mappez les URL de classement en tant que pages de destination.

Étape 3. Activez l'enregistrement de l'historique SERP pour enregistrer les 30 premiers résultats à chaque vérification de classement.

Étape 4. De plus, vous pouvez suivre les classements de vos principaux concurrents pour les mots clés ciblés. De cette façon, vous pouvez rapidement voir si l'impact sur le classement est sectoriel ou se produit uniquement sur votre site Web.

Étape 5. Ajoutez une tâche automatique pour vérifier régulièrement les classements. L'outil restera en mode veille et vérifiera les classements en mode pilote automatique à la date définie.

Le suivi du classement vous fournira un ensemble de données suffisant pour diagnostiquer les pénalités de Google.

Dans l’outil de suivi, examinez s’il y a une forte baisse du classement pour vos mots clés cibles.

Si oui, comparez-les avec vos concurrents les plus proches pour vérifier s’ils vivent la même situation.

Consultez également le graphique de fluctuation sous les détails SERP. Lorsque vous remarquez une forte volatilité dans les résultats de recherche, il est fort probable que Google mette à jour quelque chose dans ses algorithmes.

À moins qu’il ne s’agisse d’une mise à jour massive de Google, auditez votre site pour repérer les problèmes techniques probables qui pourraient affecter ses performances.

La récupération après une pénalité manuelle dépend de chaque cas particulier, de sa difficulté et des types de correctifs à effectuer. La récupération d'un site peut prendre de quelques semaines à plusieurs mois.

La notification de pénalité dans la console donne généralement une idée de la nature des problèmes et de la manière dont ils enfreignent les principes de base de la recherche de Google (anciennement les directives pour les webmasters). Cependant, les spécialistes du référencement ont besoin de temps pour les examiner en détail.

Ensuite, ils soumettent une demande de révision des sanctions dans la Search Console. Et il faudra du temps à Google pour examiner la demande, il est donc préférable de la rendre simple. Une bonne demande:

Ensuite, la console affichera le message d'état de révision pour vous faire savoir si votre demande est prise en compte et si la pénalité est révoquée.

La plupart des demandes envoyées à Google sont soit approuvées, soit rejetées. Parfois, le message indique que la demande est en cours de traitement et que la pénalité reste en vigueur pour d'autres violations qui n'ont pas encore été corrigées.

Avec les pénalités algorithmiques, les choses sont moins claires car il est parfois difficile d'identifier quand une pénalité spécifique est en action. Vous devrez d'abord auditer votre site et votre contenu pour en découvrir les causes.

Les mises à jour de Google entraînent souvent des problèmes de classement. Lorsque vos classements ne réapparaissent pas peu de temps après une mise à jour, il s'agit probablement d'une pénalité algorithmique appliquée pour un certain problème sur le site Web.

Comme l'a dit John Mueller lors des heures de bureau de Google SEO:

« Il est généralement judicieux de supprimer le contenu de mauvaise qualité ou le contenu indésirable que vous avez pu créer par le passé. Pour les actions algorithmiques, il peut nous falloir plusieurs mois pour réévaluer votre site afin de déterminer qu'il ne s'agit plus d'un contenu indésirable. »

Selon Google, si un site perd des positions dans les classements après une mise à jour de base, cela peut être lié à des problèmes EEAT. En d'autres termes, le site Web manque généralement d'autorité, d'expertise, de confiance ou d'expérience. Et il peut falloir des mois pour établir ces signaux.

Examinons de plus près les mauvaises pratiques qui peuvent entraîner une pénalité Google et pourquoi vous devriez les éviter.

En bref, voici ce qui peut déclencher une pénalité Google:

Le bourrage de mots-clés est une tactique SEO obsolète qui consiste à insérer de nombreux mots-clés pour classer une page de manière artificielle. Les phrases clés bourrées apparaissent souvent sur une page de manière anormale ou hors contexte, parfois sous forme de listes, ce qui constitue un facteur de classement SEO négatif confirmé.

Le bourrage de mots-clés s'accompagne souvent de techniques de référencement trompeuses, telles que le cloaking, le content spinning, etc., qui constituent ensemble un moyen infaillible de sanctions.

Le correctif

L'algorithme Panda pénalise le contenu sur-optimisé et, au lieu de classer une page surchargée, il fera exactement le contraire. Lorsque vous savez qu'aucune technique de black hat n'est mise en œuvre sur vos pages, examinez attentivement votre contenu. Vous pouvez obtenir de l'aide de Content Editor pour créer des pages correctement optimisées. De plus, il existe diverses plateformes de marketing de contenu qui facilitent grandement le processus de création de contenu.

Télécharger WebSite AuditorLe contenu léger est celui qui n'apporte que peu ou pas de valeur à l'utilisateur. Avoir quelques pages de mauvaise qualité n'est pas un problème. Mais si un site comporte de nombreuses pages qui ne sont pas utiles aux visiteurs, les algorithmes affecteront leur classement.

Les raisons d'un contenu faible peuvent être diverses. Par exemple, un site est généré à la hâte à l'aide d'outils automatiques. Un autre exemple est un site de commerce électronique avec des pages de produits faibles et sans descriptions d'articles. Les sites Web ou blogs affiliés peuvent également sembler avoir un contenu faible lorsqu'ils ne disposent pas de signaux EEAT.

Le correctif

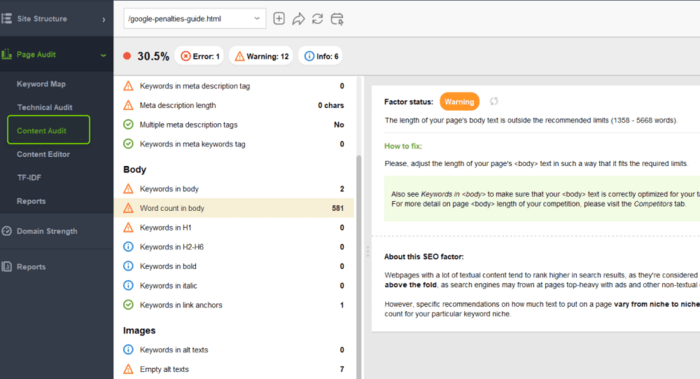

Tout d'abord, identifiez les pages avec un contenu léger. Le moyen le plus simple est de trouver des pages avec un nombre de mots faible, ce qui peut signifier que les pages n'apportent que peu de valeur aux utilisateurs.

Dans WebSite Auditor, dans le module Audit de site, filtrez toutes les pages par nombre de mots et examinez celles qui en contiennent le moins. En fait, il n'existe pas de plage stricte pour un nombre de mots idéal: cela dépend du type de page et de l'objectif pour lequel elle a été créée.

Télécharger WebSite AuditorDeuxièmement, recherchez les articles de blog mal rédigés qui n'apportent aucune valeur ajoutée. Par exemple, dans Google Analytics, recherchez les pages qui n'apportent aucun trafic organique ou qui obtiennent les taux de rebond les plus élevés.

Réécrivez les pages concernées pour créer un article approfondi répondant à l'intention de recherche de vos visiteurs. Suivez les conseils d'optimisation de la section Audit de contenu.

Vous pouvez également utiliser l'éditeur de contenu ici pour trouver des sujets populaires connexes et des questions fréquemment posées qui ajoutent plus d'informations à votre sujet. Entre autres choses, cet outil affiche le nombre de mots minimal et maximal sur les pages les mieux classées pour votre requête cible.

Le problème avec les sites Web affiliés est qu'ils ne sont parfois que des copies du site Web du commerçant, n'apportant aucune valeur ajoutée aux utilisateurs. Le moteur de recherche, trouvant des sites Web similaires, les regroupe et classe le principal parmi tous ceux-ci.

Le correctif

Si vous faites du marketing d’affiliation, respectez les meilleures pratiques:

Cela peut paraître surprenant, mais il n'existe pas de pénalité pour le contenu dupliqué en tant que tel, « du moins, pas dans le sens où la plupart des gens l'entendent lorsqu'ils disent cela », explique Google.

Le problème des doublons est que vous gaspillez votre budget d'exploration de site. Les robots de recherche peuvent se tromper sur l'URL à présenter à l'utilisateur. De cette façon, des pages inutiles apparaissent dans les recherches, les visiteurs s'énervent et, par conséquent, le classement et le trafic de votre site Web sont endommagés.

Les choses sont plutôt simples avec les duplications externes. Google pénalise le contenu copié ou syndiqué identique à l'intégralité du site Web d'origine.

« La seule fois où nous aurions une sorte de pénalité ou une action algorithmique ou manuelle, c'est lorsque l'ensemble du site Web est constitué uniquement de contenu dupliqué... s'il s'agit d'un site Web qui récupère d'autres sites Web par exemple. »

Ainsi, pour éviter les pénalités de duplication, faites attention aux cas où quelqu'un crée une copie de votre site Web quelque part sur le Web. Pour le reste, gardez votre site sans doublons en suivant les meilleures pratiques.

Le correctif

Pour éviter la duplication à l'échelle du site qui n'entraînera pas de pénalité manuelle mais qui peut avoir un impact sur votre classement, assurez-vous que:

Le contenu généré automatiquement par spam est un contenu généré par programmation qui manque de cohérence ou n'apporte que peu de valeur aux utilisateurs. Ce type de contenu est créé dans le seul but de manipuler les classements de recherche. Il n'est donc pas étonnant que Google ait déployé de nombreux efforts pour éliminer le spam des SERP.

Voici des exemples de contenu spammé généré automatiquement qui peuvent être pénalisés:

L'histoire du contenu généré automatiquement a pris une tournure intéressante après l'arrivée de la technologie GPT-3 et d'Open AI. Cet outil peut générer des textes impressionnants qui ressemblent beaucoup à du contenu écrit par un humain. Mais est-ce que cela garantit que ce contenu généré automatiquement ne sera pas traité comme du spam?

Il y a deux problèmes ici. Tout d’abord, il est douteux que nous puissions encore nous fier à l’exactitude du contenu généré par l’IA. La question est de savoir si les éditeurs de sites Web qui ont recours à la génération de contenu par l’IA accorderont l’attention nécessaire à la vérification (en particulier lorsqu’il s’agit de faits récents, de tendances émergentes, d’actualités ou de tout ce que l’IA ne « sait » pas encore avec certitude).

Deuxièmement, grâce aux outils d’IA, la quantité de contenu pourrait croître de manière exponentielle. Il faudra donc beaucoup plus de capacité pour le traiter, et Google doit relever le défi.

Le correctif

Si vous avez beaucoup de contenu généré automatiquement qui a entraîné une pénalité Google, il existe plusieurs étapes à suivre pour le gérer:

Habituellement, le spam des utilisateurs apparaît dans les commentaires sous les articles de blog, sur les forums, dans les comptes de réseaux sociaux populaires, etc. Ces commentaires sont souvent générés par des outils automatiques uniquement pour acquérir des backlinks SEO.

Les spams générés par les utilisateurs nuisent à la qualité d'un site car ils diluent le PageRank et sont souvent sans rapport avec le contenu principal. Trop de commentaires de ce type sur l'ensemble du site peuvent conduire le site directement sous le coup d'une pénalité de Google.

Le correctif

Si vous détectez des commentaires non naturels sur vos pages, supprimez-les tout simplement. Mais il est plus facile de prévenir le spam que de le nettoyer plus tard. Certaines plateformes préfèrent même fermer les sections de commentaires si elles n'ont pas les ressources pour les surveiller.

Cependant, si vous avez besoin de commentaires sur votre site Web, il existe quelques bonnes pratiques pour éviter le spam généré par les utilisateurs:

Les pages de passerelle (parfois appelées pages de saut ou pages de pont) sont une technique de spamdexing dans laquelle les pages intermédiaires sont optimisées pour se classer pour des requêtes similaires spécifiques et ne sont pas aussi utiles que la destination finale. En d'autres termes, ce sont des portes qui occupent une grande partie de l'espace SERP et canalisent les utilisateurs vers un seul site Web.

D'après cette description, les portes véritablement dangereuses répondent aux critères suivants:

Les portes d'entrée perturbent l'expérience de recherche et induisent les utilisateurs en erreur. Les moteurs de recherche tentent donc de les repérer et de les pénaliser.

Le correctif

Pour les pages de porte intentionnelles, le seul conseil est de ne pas le faire. Ainsi, si vous avez créé des pages de porte et que vous avez été pénalisé, supprimez celles qui contiennent des balises noindex et supprimez-les du plan de site. Créez plutôt un contenu de valeur qui répond aux intentions des internautes et appliquez toutes les meilleures pratiques de référencement pour obtenir un bon classement.

Vérifiez également vos redirections pour vous assurer qu'elles mènent à la bonne destination. Vous pouvez obtenir rapidement une liste de toutes vos redirections 301/302 dans la section Audit de site de WebSite Auditor.

Le cloaking est une autre technique de référencement black hat dans laquelle les utilisateurs et les robots des moteurs de recherche voient un contenu différent sur la même page. En termes simples, une page est classée pour un ensemble de mots-clés, pour lequel il est plus facile de se classer, mais qui montre autre chose.

Une méthode de masquage à l'ancienne consiste à masquer des mots-clés ou des liens sur une page à l'aide de la couleur, de la taille, des styles CSS, etc. Certaines formes de masquage plus sophistiquées sont mises en œuvre en identifiant l'agent utilisateur, l'IP, le référent, etc., pour proposer différentes versions de pages Web à un humain et à Googlebot.

Le masquage étant contraire aux consignes pour les webmasters, il peut entraîner une pénalité manuelle. Il arrive parfois que des pages masquées apparaissent tout de même dans les recherches. Comment cela se fait-il?

En 2018 et aujourd'hui en 2023, Google a confirmé qu'il était capable de reconnaître le texte invisible et de l'ignorer. Selon John Mueller, si une page avec du texte caché est classée, cela peut être pour d'autres raisons.

Et les expériences montrent que le texte caché n'améliore pas le classement de ces mots cachés, il est donc tout simplement inutile.

Il existe des cas où la diffusion d'une version légèrement différente du contenu est appropriée et n'est pas considérée comme du cloaking. Par exemple, les paywalls, en substance, montrent des éléments différents aux utilisateurs et aux moteurs de recherche. Google fournit des directives d'échantillonnage flexibles pour le contenu payant et prend en charge les données structurées pour le différencier du cloaking.

Le correctif

Tout d’abord, dans la Search Console, vous pouvez examiner votre page avec l’ outil d’inspection d’URL pour vérifier comment Googlebot la voit.

Vous pouvez également utiliser WebSite Auditor pour analyser vos pages et détecter les éléments invisibles. Dans les paramètres avancés du projet, vous pouvez choisir le robot d'exploration Googlebot ou Googlebot-Mobile pour examiner le contenu de vos pages. Il est probablement préférable de demander à votre technicien de rechercher et de supprimer les scripts inappropriés.

Télécharger WebSite AuditorDepuis plus d’une décennie, Google trouve des moyens de pénaliser les pratiques de manipulation des liens – c’est ainsi qu’apparaissent les algorithmes Penguin et SpamBrain. Pourtant, ici et là, on entend quelqu’un dire que les liens fonctionnent, y compris les liens payants.

Google nous dit qu'il sait différencier et ignorer les mauvais liens. Pourtant, les mises à jour de spam de liens ainsi que la possibilité d'obtenir une action manuelle servent de rappel: les webmasters doivent faire attention à la qualité des profils de liens de leurs sites Web.

Voici une liste de signaux indiquant qu'un site pourrait être impliqué dans des pratiques de création de liens manipulatrices:

Le correctif

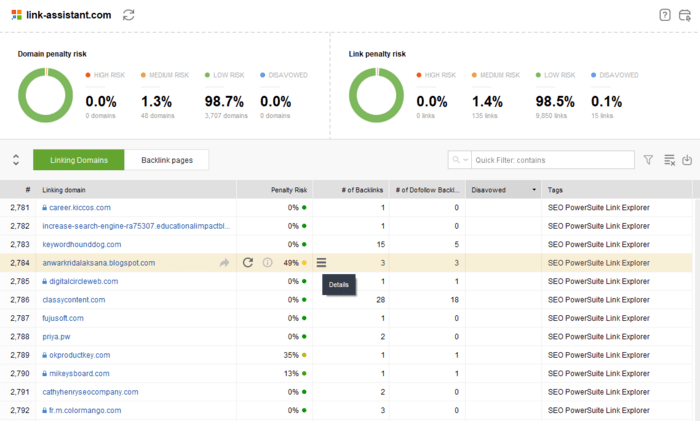

Vous pouvez utiliser SEO SpyGlass pour évaluer les backlinks pointant vers un site Web et évaluer le risque potentiel d'obtenir une pénalité. De plus, vous pouvez intégrer d'autres sources de liens, notamment Search Console.

Télécharger SEO SpyGlassLe vérificateur de backlink évalue la qualité d'un lien et calcule le score de risque de pénalité qui prend en compte des facteurs tels que l'âge du domaine, le texte d'ancrage, le nombre et la qualité des backlinks entrants, les liens sur l'ensemble du site, l'autorité de la page/du domaine, la diversité IP, etc.

Ainsi, pour corriger une pénalité pour les liens suspects, procédez comme suit:

Le moteur de recherche prend en compte à la fois les liens entrants et sortants. Citer des sources fiables peut être un signe supplémentaire de confiance pour les internautes. En revanche, des liens sortants excessifs (en particulier depuis le même répertoire vers des sites Web non pertinents) peuvent signifier que le site Web vend des liens.

Le correctif

Vérifiez vos liens dans l'onglet Toutes les pages > In Link Rank de Website Auditor. InLink Rank est une mesure qui estime l'importance d'une page en fonction du nombre et de la qualité des liens, entrants et sortants. Les URL avec un InLink Rank faible peuvent signifier qu'il peut y avoir un problème avec les liens sur la page.

Vous pouvez sélectionner chaque URL (en particulier celles qui contiennent le plus grand nombre de liens) et examiner les liens de la page dans la moitié inférieure de l'espace de travail. Il existe un filtre rapide pour trier tous les liens externes.

Télécharger WebSite AuditorSi vous avez trouvé des liens sortants suspects qui ne sont pas pertinents par rapport au contenu, trop nombreux, etc., marquez-les comme nofollow ou supprimez-les.

Gardez à l'esprit qu'il n'y a rien de mal à avoir des liens payants, mais dans ce cas, vous devez les marquer comme sponsorisés.

Les données structurées sont un outil puissant utilisé pour améliorer les résultats et saisir plus de contenu sur les SERP. Cependant, les erreurs dans les données structurées, intentionnelles ou occasionnelles, peuvent entraîner des pénalités manuelles.

La documentation de Google indique qu'une action manuelle impliquant des données structurées signifie qu'une page perd son éligibilité à apparaître comme un résultat enrichi. Cependant, Google a récemment précisé qu'une action manuelle impliquant des données structurées pourrait également avoir un impact sur les classements.

Il n’est pas toujours facile d’identifier les erreurs de schéma, car même si l’ outil de test des données structurées a validé votre balisage, cela ne signifie pas que tout va bien.

Ainsi, les erreurs de balisage typiques qui peuvent entraîner des pénalités sont les suivantes:

Le correctif

La Search Console affiche des erreurs de balisage dans la section Améliorations. Ces erreurs peuvent avoir un impact sur l'apparence de votre SERP et entraîner la perte de fonctionnalités riches et de tonnes de trafic. Elles doivent donc être corrigées.

Chaque type de données structurées possède ses propres directives techniques et de recherche. Veillez donc à les lire attentivement avant d'implémenter le balisage. Vous pouvez également consulter notre guide de balisage de schéma pour plus de détails.

Si vous avez été pénalisé, vérifiez votre balisage et corrigez les problèmes. WebSite Auditor vous aidera à collecter la liste de toutes les pages comportant un balisage. Accédez à Structure du site > Pages et consultez l'onglet Ouvrir le graphique et les données structurées.

Télécharger WebSite AuditorLes premières sanctions pour les publicités intrusives sont apparues avec la mise à jour de l'algorithme Page Layout en 2012. L'algorithme pénalisait les sites Web pour les publicités statiques excessives au-dessus de la ligne de flottaison. Plus tard, l'algorithme Intrusive Interstitials a ajouté les fenêtres contextuelles et les publicités superposées à la liste des pratiques de conception à proscrire.

Les pénalités sont appliquées de manière algorithmique dès que des interstitiels intrusifs apparaissent sur une page. En général, vous remarquerez une baisse des impressions et des clics, puis un retour en arrière une fois l'élément interférent supprimé.

Le correctif

Tout d'abord, évitez les interstitiels intrusifs sur votre site. Respectez les bonnes pratiques en matière de conception de pages, tant pour les ordinateurs de bureau que pour les appareils mobiles. Par exemple, retardez l'affichage des fenêtres contextuelles et autres boutons d'interaction jusqu'à ce que le visiteur décide de quitter le site.

Consultez également votre rapport sur l'expérience de page dans la console Google (idéalement, toutes vos pages doivent être de bonnes URL). Et utilisez WebSite Auditor pour auditer toutes les pages en masse et vous assurer que chaque page obtient les scores Core Web Vitals les plus élevés possibles.

Une grande partie du contenu de News and Discover peut être pénalisée pour désinformation et violation des règles. Cela concerne principalement les sujets sensibles de YMYL, qui nécessitent davantage de preuves et de précision, tels que les sites d'actualités, les soins de santé, les finances, etc.

Le correctif

La seule façon de résoudre les problèmes de contenu trompeur est de supprimer la cause du problème et de demander un réexamen.

Pour éviter les pénalités sur vos sites YMYL, assurez-vous de ne pas publier:

Il peut également y avoir des avis de pénalité indiquant qu'un site partage un hébergement gratuit contenant du spam. Même si ce site Web ne fait rien de mal, il peut recevoir un avis de pénalité indiquant que l'hébergement gratuit est utilisé de manière abusive par des spammeurs tiers.

En conséquence, le site Web perdra en visibilité, en classement et en fonctionnalités de recherche. Cependant, il restera indexé.

Le correctif

Optez pour un hébergement sécurisé. Nous vous proposons ici un bref aperçu de tous les aspects du choix d'un hébergement fiable.

Un contenu piraté signifie que du contenu ou du code a été ajouté à un site à l'insu du propriétaire en raison de failles dans la sécurité du site Web. Par conséquent, le site peut contenir des liens cachés, des redirections sournoises, des pages trompeuses, etc.

Les sites Web piratés sont utilisés dans différentes formes de cybercriminalité. Le problème est que de telles violations nuisent non seulement au site Web piraté, mais également à ses visiteurs.

Les sites Web sanctionnés pour piratage de contenu ne sont pas supprimés de Google, mais ils affichent un avertissement concernant une menace potentielle à côté de l'URL dans la SERP. Après avoir cliqué sur l'URL, l'utilisateur verra un avertissement en plein écran indiquant que le site est potentiellement dangereux.

Google envoie un message au propriétaire du site concernant le contenu piraté ainsi que l'URL concernée. Contrairement à toutes les autres pénalités manuelles, l'avertissement apparaît dans l'onglet Problèmes de sécurité.

De plus, n'importe qui peut vérifier le statut d'un site concernant le contenu dangereux dans le rapport de transparence de Google. Fait remarquable, le rapport global montre que le nombre d'avertissements de sécurité de recherche a considérablement diminué par rapport à il y a cinq ans.

Le correctif

Si votre site a reçu une alerte de problème de sécurité, vous devrez d’abord analyser le site Web pour détecter la vulnérabilité et l’éliminer.

Ensuite, pour améliorer la sécurité de votre site Web, tenez compte des conseils suivants:

Cette liste de pénalités Google n'a pas vocation à être exhaustive. Elle présente plutôt différents types de problèmes pouvant entraîner une sanction et comment les résoudre. Ainsi, si vous recevez une pénalité, vous saurez quoi faire (mais j'espère que vous n'en recevrez pas, car le référencement white hat est le meilleur, n'est-ce pas?)

Quelle a été la sanction Google la plus sévère dont vous ayez été victime? Nous aimerions connaître votre avis dans nos groupes d'utilisateurs sur Facebook et Twitter.