71755

•

16-minutę czytania

•

Kary Google są wyjątkowo nieprzyjemne dla właścicieli witryn, zwłaszcza tych, którzy polegają na organicznych wynikach wyszukiwania w celu uzyskania dochodu. Ten przewodnik podsumowuje wszystkie główne powody algorytmicznych i ręcznych kar Google, podaje wskazówki dotyczące odzyskiwania i środki zapobiegawcze.

Kara Google to negatywny wpływ na pozycję witryny w wynikach wyszukiwania z powodu naruszenia wytycznych Google dla webmasterów. Może to wynikać z aktualizacji algorytmicznych lub ręcznych działań w przypadku problemów, takich jak spam, upychanie słów kluczowych lub nienaturalne linki zwrotne. Kary zmniejszają widoczność witryny w wynikach wyszukiwania, co wpływa na ruch i wydajność.

Kary nakładane przez Google można podzielić na następujące typy:

Ze względu na zakres wpływu kary Google dzielą się na:

Google obserwuje jakość wyszukiwania za pomocą algorytmów, jak również ludzkich oceniających jakość. Ponadto istnieje narzędzie dla każdego, aby zgłosić złośliwą treść, phishing, płatne linki lub spam.

Jeśli zdarzy Ci się stosować black-hat lub gray-hat SEO i otrzymasz karę, pilnie musisz rozwiązać problem. Nawet jeśli tylko część Twoich stron została dotknięta, ogólny autorytet domeny spadnie i będzie miała problemy z uzyskaniem pozycji w pozostałych zapytaniach.

Jednak nawet po usunięciu treści lub linków, które doprowadziły do nałożenia sankcji przez Google, nie gwarantuje to, że wszystkie Twoje rankingi zostaną przywrócone do poziomu sprzed nałożenia kary. Lepiej więc dmuchać na zimne – sprawdź, dlaczego kary Google mogą zostać nałożone i zapobiegaj im.

Odzyskiwanie kary Google to proces przywracania widoczności witryny w wyszukiwarkach i ruchu po karze od Google. Obejmuje to identyfikację przyczyny — takiej jak niska jakość treści, spamerskie linki zwrotne lub problemy techniczne — i podejmowanie działań naprawczych, takich jak odrzucanie szkodliwych linków, poprawa jakości treści i zapewnienie zgodności z wytycznymi Google w celu odzyskania rankingów i zasięgu indeksu.

Wykrywanie kar ręcznych jest bardzo proste: zaznacz pole Manual actions w Google Search Console. Na zdrowej stronie zobaczysz komunikat informujący, że wszystko jest w porządku. Aby dowiedzieć się, czy w przeszłości były jakieś zawiadomienia karne, możesz przejrzeć wiadomości pod ikoną dzwonka w prawym górnym rogu.

Jeśli będziesz miał pecha, zobaczysz czerwoną notę karną informującą o wykrytych problemach.

Jak to często bywa w przypadku działań ręcznych, SEO wiedzą, kogo obwinić. Problem może wystąpić z powodu płatnych linków, upychania słów kluczowych, automatycznie generowanej treści – czegokolwiek, co zostało celowo dodane do stron w celu manipulowania rankingami.

Aby wykryć częściowe lub algorytmiczne kary (za które nie są przekazywane żadne powiadomienia), musisz regularnie obserwować rankingi. Zobaczmy, jak skonfigurować regularne śledzenie, aby obserwować anomalie w Rank Tracker (pamiętaj, że będziesz potrzebować licencji Professional lub Enterprise).

Krok 1. Uruchom narzędzie i dodaj adres URL swojej witryny, aby utworzyć projekt.

Krok 2. Dodaj docelowe słowa kluczowe do funkcji Rank Tracking i zamapuj adresy URL rankingowe jako strony docelowe.

Krok 3. Włącz opcję Rejestrowanie historii SERP, aby rejestrować 30 najlepszych wyników przy każdej kontroli rankingu.

Krok 4. Ponadto możesz śledzić rankingi swoich głównych konkurentów dla docelowych słów kluczowych. W ten sposób możesz szybko sprawdzić, czy wpływ na ranking jest branżowy, czy występuje tylko na Twojej stronie internetowej.

Krok 5. Dodaj automatyczne zadanie, aby regularnie sprawdzać rankingi. Narzędzie pozostanie w trybie gotowości i będzie sprawdzać rankingi na autopilocie w ustalonym dniu.

Monitorowanie pozycji w rankingu dostarczy Ci zestawu danych wystarczających do zdiagnozowania kar nałożonych przez Google.

W narzędziu śledzącym sprawdź, czy nastąpił gwałtowny spadek pozycji dla docelowych słów kluczowych.

Jeśli tak, porównaj je z wynikami swoich najbliższych konkurentów i sprawdź, czy mają takie same doświadczenia.

Sprawdź także wykres fluktuacji w szczegółach SERP. Kiedy zauważysz dużą zmienność w wynikach wyszukiwania, najprawdopodobniej Google aktualizuje coś w swoich algorytmach.

Jeżeli nie jest to poważna aktualizacja Google, przeprowadź audyt swojej witryny, aby wykryć prawdopodobne problemy techniczne, które mogą wpływać na jej wydajność.

Odzyskiwanie po karze ręcznej zależy od konkretnego przypadku, jego trudności i rodzajów poprawek do wykonania. Odzyskiwanie witryny może potrwać od kilku tygodni do kilku miesięcy.

Powiadomienie o karze w Konsoli zwykle daje wskazówkę, jakie są problemy i w jaki sposób naruszają zasady Google Search Essentials (dawniej Webmaster Guidelines). Jednak specjaliści SEO potrzebują czasu, aby je szczegółowo zbadać.

Następnie składają wniosek o sprawdzenie sankcji w Search Console. Google będzie potrzebowało czasu, aby rozważyć wniosek, więc lepiej jest go uprościć. Dobry wniosek:

Następnie Konsola wyświetli komunikat o statusie przeglądu, aby poinformować, czy Twoja prośba została rozpatrzona, a kara anulowana.

Większość próśb przesłanych do Google jest albo akceptowana, albo odrzucana. Czasami wiadomość głosi, że prośba jest przetwarzana, a kara pozostaje za inne naruszenia, które nie zostały jeszcze naprawione.

W przypadku kar algorytmicznych sprawy są mniej jasne, ponieważ czasami trudno jest zidentyfikować, kiedy konkretna kara jest stosowana. Najpierw musisz przeprowadzić audyt swojej witryny i treści, aby znaleźć przyczyny.

Aktualizacje Google często powodują problemy z rankingiem. Jeśli Twoje rankingi nie wracają po krótkim czasie od aktualizacji, prawdopodobnie jest to algorytmiczna kara stosowana za pewien problem na stronie internetowej.

Jak powiedział John Mueller w godzinach pracy biura Google SEO:

„Zasadniczo dobrym pomysłem jest oczyszczenie treści niskiej jakości lub treści spamowych, które mogłeś stworzyć w przeszłości. W przypadku działań algorytmicznych może nam zająć kilka miesięcy, aby ponownie ocenić Twoją witrynę i ustalić, że nie jest już spamem”.

Według Google, jeśli witryna straciła pozycję po aktualizacji rdzenia, może to być powiązane z problemami EEAT. Oznacza to, że witryna zazwyczaj nie ma autorytetu, wiedzy, zaufania lub doświadczenia. A ustanowienie tych sygnałów może zająć miesiące.

Przyjrzyjmy się bliżej, jakie złe praktyki mogą skutkować karą od Google i dlaczego warto ich unikać.

Krótko mówiąc, oto co może spowodować nałożenie kary przez Google:

Keyword stuffing to przestarzała taktyka SEO polegająca na wstawianiu wielu słów kluczowych w celu sztucznego pozycjonowania strony. Wypchane frazy kluczowe często pojawiają się na stronie nienaturalnie lub poza kontekstem, czasami w formie list, i jest to potwierdzony negatywny czynnik rankingowy SEO.

Upychanie słów kluczowych często idzie w parze z oszukańczymi technikami SEO, takimi jak maskowanie, manipulowanie treścią itp., które razem są pewnym sposobem na nałożenie sankcji.

Naprawa

Algorytm Panda karze nadmiernie zoptymalizowaną treść i zamiast pozycjonować wypchaną stronę wyżej, zrobi dokładnie odwrotnie. Kiedy wiesz, że na Twoich stronach nie zastosowano żadnych technik black-hat, dokładnie przejrzyj swoją treść. Możesz uzyskać pomoc od Content Editora, aby utworzyć prawidłowo zoptymalizowane strony. Ponadto istnieją różne platformy marketingu treści, które znacznie ułatwiają proces tworzenia treści.

Pobierz WebSite AuditorTreść o małej wartości to taka, która daje użytkownikowi małą lub żadną wartość. Nie stanowi problemu posiadanie kilku stron o niskiej jakości. Ale jeśli witryna ma wiele stron, które nie są przydatne dla odwiedzających, algorytmy wpłyną na ich rankingi.

Powody cienkiej treści mogą być różne. Na przykład witryna jest generowana w pośpiechu za pomocą narzędzi automatycznych. Innym przykładem jest witryna e-commerce z cienkimi stronami produktów, na których brakuje opisów przedmiotów. Witryny partnerskie lub blogi mogą również wydawać się cienkie, gdy brakuje im sygnałów EEAT.

Naprawa

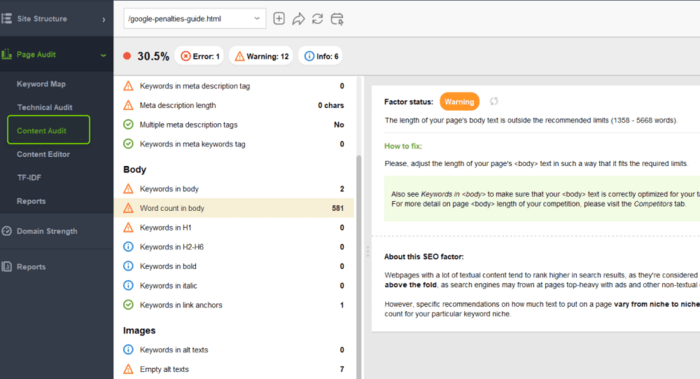

Po pierwsze, zidentyfikuj strony z niewielką zawartością. Najłatwiejszym sposobem jest znalezienie stron z małą liczbą słów, co może oznaczać, że strony te dają użytkownikom niewielką wartość.

W WebSite Auditor, w module Site Audit, filtruj wszystkie strony według liczby słów i sprawdzaj te, które mają najmniej słów. Właściwie nie ma ścisłego zakresu idealnej liczby słów: zależy to od typu strony i celu, dla którego została utworzona.

Pobierz WebSite AuditorPo drugie, znajdź źle napisane posty na blogu, które nie wnoszą żadnej wartości. Na przykład w Google Analytics poszukaj stron, które nie przynoszą żadnego ruchu organicznego lub mają najwyższe współczynniki odrzuceń.

Przepisz dotknięte strony, aby utworzyć dogłębny post spełniający intencję wyszukiwania odwiedzających. Postępuj zgodnie z poradami dotyczącymi optymalizacji z sekcji Content Audit.

Możesz również użyć Content Editor tutaj, aby znaleźć popularne powiązane tematy i często zadawane pytania, które dodadzą więcej informacji do Twojego tematu. To narzędzie pokazuje między innymi minimalną i maksymalną liczbę słów na najlepiej ocenianych stronach dla Twojego zapytania docelowego.

Rzecz w witrynach partnerskich jest taka, że czasami są one po prostu kopiami witryny handlowej, nie dodając żadnej wartości użytkownikom. Wyszukiwarka, znajdując podobne szablonowe witryny, grupuje je razem i klasyfikuje główną z nich.

Naprawa

Jeśli zajmujesz się marketingiem afiliacyjnym, trzymaj się najlepszych praktyk:

Może to być zaskakujące, ale za duplikację treści jako takiej nie przewidziano żadnej kary, „przynajmniej nie w znaczeniu, jakie ma na myśli większość ludzi” – twierdzi Google.

Cały problem z duplikacjami polega na marnowaniu budżetu na indeksowanie witryny. Roboty wyszukiwawcze mogą się pogubić, który adres URL przedstawić użytkownikowi. W ten sposób niepotrzebne strony pojawiają się w wynikach wyszukiwania, odwiedzający się denerwują, a w konsekwencji rankingi witryny i ruch ulegają pogorszeniu.

Rzeczy są dość proste w przypadku duplikacji zewnętrznych. Google karze treści zeskrobane lub syndykowane, które są identyczne z całą oryginalną witryną.

„Jedyną sytuacją, w której możemy mieć do czynienia z karą lub działaniem algorytmicznym lub ręcznym, jest sytuacja, w której cała witryna składa się wyłącznie z zduplikowanej treści… na przykład gdy jedna witryna pobiera dane z innych witryn”.

Dlatego, aby uniknąć kar za duplikację, uważaj na przypadki, gdy ktoś tworzy kopię Twojej witryny gdzieś w sieci. Poza tym utrzymuj swoją witrynę bez duplikatów, postępując zgodnie z najlepszymi praktykami.

Naprawa

Aby zapobiec duplikacji w całej witrynie, co nie spowoduje nałożenia kary, ale może wpłynąć na pozycję w wynikach wyszukiwania, należy upewnić się, że:

Spamowa, automatycznie generowana treść to treść, która została wygenerowana programowo i nie jest spójna lub dodaje niewielką wartość dla użytkowników. Taka treść jest tworzona w jedynym celu manipulowania rankingami wyszukiwania, nic dziwnego, że Google włożyło wiele wysiłku w wyeliminowanie spamu z SERP-ów.

Przykłady automatycznie generowanej treści spamerskiej, która może zostać ukarana, obejmują:

Historia z automatycznie generowaną treścią nabrała ciekawego zwrotu akcji po pojawieniu się technologii GPT-3 i Open AI. To narzędzie może generować niesamowite teksty, które wyglądają dość podobnie do treści pisanych przez ludzi. Ale czy zapewnia, że taka automatycznie generowana treść nie będzie traktowana jako spam?

Są tu dwa problemy. Po pierwsze, na razie wątpliwe jest, czy możemy polegać na dokładności treści generowanych przez AI. Pytanie brzmi, czy redaktorzy stron internetowych, którzy uciekają się do generowania treści przez AI, zwrócą należytą uwagę na weryfikację (szczególnie dotyczy to ostatnich faktów, pojawiających się trendów, wiadomości lub czegokolwiek, czego AI jeszcze na pewno nie „wie”).

Po drugie, dzięki narzędziom AI ilość treści może wzrosnąć wykładniczo. Będzie więc wymagać znacznie większej pojemności do jej przetworzenia, a Google musi stawić czoła wyzwaniu.

Naprawa

Jeśli masz dużo treści generowanych automatycznie, które skutkowały karą Google, istnieje kilka kroków, które można podjąć, aby sobie z tym poradzić:

Zazwyczaj spam użytkowników pojawia się w komentarzach pod postami na blogach, na forach, w popularnych kontach mediów społecznościowych itp. Takie komentarze są często generowane przez automatyczne narzędzia wyłącznie w celu pozyskania linków zwrotnych SEO.

Spam generowany przez użytkowników szkodzi jakości witryny, ponieważ rozwadnia PageRank i często jest nieistotny dla głównej treści. Zbyt wiele takich komentarzy w całej witrynie może doprowadzić witrynę prosto pod karę Google.

Naprawa

Jeśli wykryjesz nienaturalne komentarze na swoich stronach, po prostu je usuń. Ale łatwiej jest zapobiegać spamowi niż czyścić go później. Niektóre platformy wolą nawet zamykać sekcje komentarzy, jeśli brakuje im zasobów do ich monitorowania.

Jeśli jednak potrzebujesz komentarzy na swojej stronie internetowej, istnieje kilka sprawdzonych metod zapobiegania spamowi generowanemu przez użytkowników:

Doorway (czasami nazywane stronami skokowymi lub stronami pomostowymi) to technika spamdexingu, w której strony pośrednie są optymalizowane pod kątem rankingu dla określonych podobnych zapytań i nie są tak przydatne jak miejsce docelowe. Innymi słowy, są to drzwi, które zajmują dużo miejsca w SERP i kierują użytkowników do jednej witryny.

Z tego opisu wynika, że naprawdę szkodliwe drzwi spełniają następujące kryteria:

Drzwi utrudniają wyszukiwanie i wprowadzają użytkowników w błąd, dlatego wyszukiwarki starają się je wykryć i ukarać.

Naprawa

W przypadku celowych doorwayów jedyną radą jest, aby tego nie robić. Tak więc, jeśli utworzyłeś strony doorway i zostałeś ukarany, usuń wszystkie z tagami noindex i usuń je z mapy witryny. Zamiast tego twórz wartościowe treści, które spełniają intencje osób wyszukujących i stosuj wszystkie najlepsze praktyki SEO, aby uzyskać wysoką pozycję.

Ponadto audytuj swoje przekierowania, aby upewnić się, że prowadzą do właściwego miejsca docelowego. Możesz szybko uzyskać listę wszystkich przekierowań 301/302 w sekcji Site Audit w WebSite Auditor.

Maskowanie to kolejna technika black-hat SEO, w której użytkownicy i boty wyszukiwarek widzą różne treści na tej samej stronie. Mówiąc prościej, strona jest klasyfikowana dla jednego zestawu słów kluczowych, dla którego łatwiej jest się klasyfikować, ale pokazuje coś innego.

Starodawną metodą maskowania jest ukrywanie słów kluczowych lub linków na stronie za pomocą koloru, rozmiaru, stylów CSS itp. Bardziej zaawansowane formy maskowania są wdrażane poprzez identyfikację agenta użytkownika, adresu IP, strony odsyłającej itp. w celu dostarczania różnych wersji strony internetowej człowiekowi i Googlebotowi.

Ponieważ maskowanie narusza wytyczne webmastera, może prowadzić do ręcznej kary. Czasami zamaskowane strony nadal pojawiają się w wynikach wyszukiwania. Jak to możliwe?

W 2018 r., a teraz w 2023 r., Google ponownie potwierdziło, że potrafi rozpoznawać niewidoczny tekst i go ignorować. Według John Mueller, jeśli strona z ukrytym tekstem jest wysoko w rankingu, może to mieć miejsce z innych powodów.

Eksperymenty pokazują, że ukryty tekst nie poprawia pozycji tych słów w wynikach wyszukiwania, więc jest po prostu bezużyteczny.

Są przypadki, gdy podawanie nieco innej wersji treści jest właściwe i nie jest uważane za maskowanie. Na przykład paywalle w istocie pokazują użytkownikom i wyszukiwarkom różne rzeczy. Google zapewnia elastyczne wytyczne dotyczące próbkowania treści objętych paywallem i obsługuje dane strukturalne, aby odróżnić je od maskowania.

Naprawa

Przede wszystkim w Search Console możesz zbadać swoją stronę za pomocą narzędzia do sprawdzania adresów URL, aby sprawdzić, jak ją widzi Googlebot.

Alternatywnie, użyj WebSite Auditor do analizy stron i wykrycia niewidocznych elementów. W zaawansowanych Ustawieniach projektu możesz wybrać Googlebota lub Googlebota-Mobile crawlera do zbadania zawartości stron. Prawdopodobnie lepiej poprosić technika o znalezienie i usunięcie nieodpowiednich skryptów.

Pobierz WebSite AuditorOd ponad dekady Google znajduje sposoby na karanie manipulacyjnych praktyk linkowych – tak powstały algorytmy Penguin i SpamBrain. Mimo to tu i ówdzie słyszymy, jak ktoś mówi, że linki działają, w tym linki płatne.

Google mówi nam, że potrafi rozróżniać i ignorować złe linki. Jednak aktualizacje spamu linków, a także potencjalne ryzyko podjęcia ręcznych działań, stanowią dobre przypomnienie: webmasterzy muszą zwracać uwagę na jakość profili linków swoich witryn.

Poniżej znajduje się lista sygnałów wskazujących, że dana witryna może być zaangażowana w manipulacyjne praktyki związane z budowaniem linków:

Naprawa

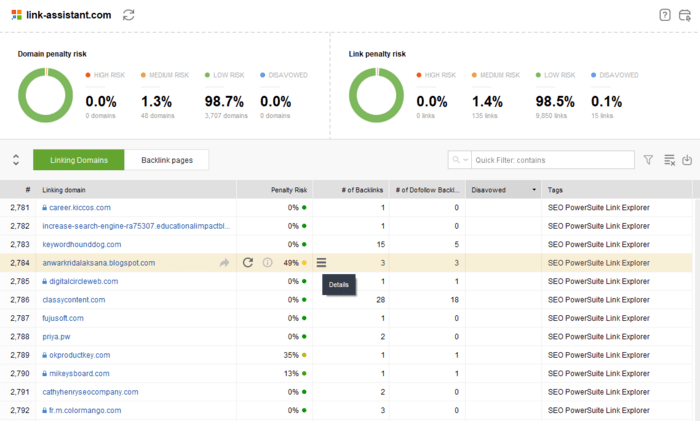

Możesz użyć SEO SpyGlass, aby ocenić linki zwrotne wskazujące na stronę internetową i ocenić potencjalne ryzyko otrzymania kary. Ponadto możesz zintegrować inne źródła linków, w tym Search Console.

Pobierz SEO SpyGlassKontroler linków zwrotnych ocenia jakość linku i oblicza wynik ryzyka kary, który bierze pod uwagę takie czynniki, jak wiek domeny, tekst zakotwiczenia, liczba i jakość przychodzących linków zwrotnych, linki w obrębie witryny, autorytet strony/domeny, różnorodność adresów IP itp.

Aby naprawić karę za podejrzane linki, wykonaj następujące czynności:

Wyszukiwarka dba zarówno o linki przychodzące, jak i wychodzące. Powoływanie się na wiarygodne źródła może być dodatkowym sygnałem zaufania dla ludzi. Tymczasem nadmierna liczba linków wychodzących (zwłaszcza z tego samego katalogu do nieistotnych stron internetowych) może oznaczać, że strona internetowa sprzedaje linki.

Naprawa

Przeprowadź audyt swoich linków w zakładce All Pages > In Link Rank w Website Auditor. InLink Rank to metryka, która szacuje ważność strony na podstawie liczby i jakości linków, zarówno przychodzących, jak i wychodzących. Adresy URL z niskim InLink Rank mogą oznaczać, że na stronie występuje problem z linkami.

Możesz wybrać każdy adres URL (zwłaszcza te z największą liczbą linków) i zbadać Linki ze strony w dolnej połowie obszaru roboczego. Jest szybki filtr do sortowania wszystkich Linków zewnętrznych.

Pobierz WebSite AuditorJeśli znajdziesz podejrzane linki wychodzące, które nie mają związku z treścią, są zbyt liczne itp., oznacz je atrybutem nofollow lub usuń.

Pamiętaj, że nie ma nic złego w zamieszczaniu linków płatnych, jednak w tym przypadku powinieneś oznaczyć je jako sponsorowane.

Ustrukturyzowane dane to potężne narzędzie służące do zwiększania wyników i pozyskiwania większej liczby pozycji w SERP-ach. Jednak błędy w ustrukturyzowanych danych, celowe lub okazjonalne, mogą prowadzić do ręcznych kar.

Dokumentacja Google stwierdza, że ręczne działanie dotyczące danych strukturalnych oznacza, że strona traci kwalifikowalność do wyświetlania jako wynik rozszerzony. Jednak Google niedawno wyjaśniło, że ręczne działanie dotyczące danych strukturalnych może również wpłynąć na rankingi.

Nie zawsze łatwo jest wskazać błędy schematu, ponieważ nawet jeśli narzędzie do testowania danych strukturalnych zweryfikowało znaczniki, nie oznacza to, że wszystko jest w porządku.

Oto typowe błędy w znacznikach, które mogą skutkować karami:

Naprawa

Search Console pokazuje błędy znaczników w sekcji Ulepszenia. Błędy te mogą wpłynąć na wygląd SERP i doprowadzić do utraty bogatych funkcji i mnóstwa ruchu, więc wymagają naprawy.

Każdy typ danych strukturalnych ma własne wytyczne techniczne i wyszukiwania, więc upewnij się, że przeczytałeś je uważnie przed wdrożeniem znaczników. Możesz również zapoznać się z naszym przewodnikiem po znacznikach schematu, aby uzyskać więcej szczegółów.

Jeśli otrzymałeś karę, sprawdź swoje znaczniki i rozwiąż problemy. WebSite Auditor pomoże Ci zebrać listę wszystkich stron z znacznikami. Przejdź do Site Structure > Pages i zobacz kartę Open graph & structured data.

Pobierz WebSite AuditorPierwsze kary za nachalne reklamy pojawiły się wraz z aktualizacją algorytmu Page Layout w 2012 r. Algorytm karał strony za nadmierne statyczne reklamy powyżej linii zagięcia. Później algorytm Intrusive Interstitials dodał wyskakujące okienka i reklamy nakładkowe do listy niedopuszczalnych praktyk projektowych.

Kary są stosowane algorytmicznie, gdy na stronie pojawią się natrętne reklamy typu interstitial. Zazwyczaj zauważysz spadek zarówno wyświetleń, jak i kliknięć – oraz wycofanie po usunięciu zakłócającego elementu.

Naprawa

Przede wszystkim unikaj nachalnych interstitiali na swojej stronie. Trzymaj się najlepszych praktyk w projektowaniu swojej strony, zarówno na komputerach stacjonarnych, jak i urządzeniach mobilnych. Na przykład opóźniaj wyskakujące okienka i inne przyciski interakcji, dopóki odwiedzający nie zdecyduje się opuścić witryny.

Sprawdź również raport Page Experience w Google Console (wszystkie Twoje strony muszą mieć dobre adresy URL, najlepiej). I użyj WebSite Auditor , aby przeprowadzić audyt wszystkich stron zbiorczo i upewnić się, że każda strona uzyska najwyższe możliwe wyniki Core Web Vitals.

Duża część treści News and Discover może zostać ukarana za dezinformację i naruszenia zasad. Dotyczy to głównie wrażliwych tematów YMYL, które wymagają więcej dowodów i dokładności, takich jak strony internetowe z wiadomościami, opieka zdrowotna, finanse itp.

Naprawa

Jedynym sposobem rozwiązania problemu wprowadzających w błąd treści jest usunięcie tego, co spowodowało problem, i prośba o ponowne rozpatrzenie sprawy.

Aby uniknąć kar nałożonych na Twoje witryny YMYL, upewnij się, że nie publikujesz:

Mogą również pojawić się zawiadomienia karne stwierdzające, że strona udostępnia spamerski darmowy hosting. Nawet jeśli ta konkretna strona nie robi nic złego, może otrzymać zawiadomienie karne stwierdzające, że darmowy hosting jest nadużywany przez zewnętrznych spamerów.

W rezultacie witryna straci widoczność, rankingi i funkcje wyszukiwania. Nadal jednak będzie indeksowana.

Naprawa

Wybierz bezpieczny hosting. Tutaj mamy krótkie podsumowanie wszystkich aspektów wyboru niezawodnego hostingu.

Zhakowana treść oznacza, że pewna treść lub kod zostały dodane do witryny bez wiedzy właściciela z powodu naruszeń bezpieczeństwa witryny. W rezultacie witryna może zawierać ukryte linki, podstępne przekierowania, oszukańcze strony itp.

Zhakowane strony internetowe są wykorzystywane w różnych formach cyberprzestępstw. Problem polega na tym, że takie naruszenia szkodzą nie tylko zhakowanej stronie internetowej, ale także jej odwiedzającym.

Witryny z karą za zhakowaną treść nie są usuwane z listy Google, ale mają ostrzeżenie o potencjalnym zagrożeniu obok adresu URL w SERP. Po kliknięciu adresu URL użytkownik zobaczy ostrzeżenie na pełnym ekranie informujące, że witryna jest potencjalnie szkodliwa.

Google wysyła wiadomość do właściciela witryny o zhakowanej zawartości wraz z dotkniętym adresem URL. W przeciwieństwie do wszystkich innych ręcznych kar, ostrzeżenie pojawia się na karcie Problemy bezpieczeństwa.

Poza tym każdy może sprawdzić status witryny pod kątem niebezpiecznej zawartości w Raporcie przejrzystości Google. Co ciekawe, ogólny raport pokazuje, że liczba ostrzeżeń dotyczących bezpieczeństwa wyszukiwania drastycznie spadła w porównaniu do pięciu lat temu.

Naprawa

Jeśli na Twojej stronie pojawił się alert dotyczący bezpieczeństwa, najpierw musisz przeskanować witrynę w celu wykrycia luk w zabezpieczeniach i ich wyeliminowania.

Następnie, aby zwiększyć bezpieczeństwo swojej witryny, weź pod uwagę następujące wskazówki:

Ta lista kar Google nie miała być wyczerpująca. Zamiast tego pokazuje różne rodzaje problemów, które mogą spowodować sankcję i jak je wszystkie naprawić. Więc jeśli dostaniesz karę, będziesz wiedział, co robić (ale mam nadzieję, że nie dostaniesz żadnej, ponieważ white-hat SEO jest najlepsze, prawda?)

Jaka była najcięższa kara Google, z której kiedykolwiek się otrząsnąłeś? Chcielibyśmy usłyszeć od Ciebie w naszych grupach użytkowników na Facebooku i Twitterze.