107946

•

20 минут чтения

•

Алгоритм PageRank (или сокращенно PR) — это система ранжирования веб-страниц, разработанная Larry Page и Sergey Brin в Стэнфордском университете в конце 90-х. PageRank на самом деле был основой, на которой Page и Brin создали поисковую систему Google.

С тех пор прошло много лет, и, конечно, алгоритмы ранжирования Google стали намного сложнее. Они все еще основаны на PageRank? Как именно PageRank влияет на рейтинг, может ли он быть одной из причин падения вашего рейтинга и к чему оптимизаторам следует быть готовыми в будущем? Теперь мы собираемся найти и обобщить все факты и загадки, связанные с PageRank, чтобы картина стала ясной. Ну, насколько можем.

Как упоминалось выше, в своем университетском исследовательском проекте Brin и Page пытались изобрести систему оценки авторитетности веб-страниц. Они решили построить эту систему на ссылках, которые служили вотумами доверия, выдаваемыми странице. Согласно логике этого механизма, чем больше внешних ресурсов ссылается на страницу, тем более ценную информацию она содержит для пользователей. А PageRank (оценка от 0 до 10, рассчитываемая на основе количества и качества входящих ссылок) показывал относительную авторитетность страницы в Интернете.

Давайте посмотрим, как работает PageRank. Каждая ссылка с одной страницы (А) на другую (Б) дает так называемый голос, вес которого зависит от коллективного веса всех страниц, ссылающихся на страницу А. И мы не можем узнать их вес, пока не рассчитаем это, поэтому процесс идет циклично.

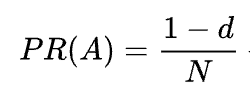

Математическая формула исходного PageRank следующая:

Где A, B, C и D — несколько страниц, L — количество ссылок, исходящих с каждой из них, а N — общее количество страниц в коллекции (т. е. в Интернете).

Что касается d, то d — это так называемый коэффициент демпфирования. Учитывая, что PageRank рассчитывается, моделируя поведение пользователя, который случайно попадает на страницу и нажимает на ссылки, мы применяем этот демпфирующий d -фактор как вероятность того, что пользователю станет скучно и он покинет страницу.

Как видно из формулы, если на страницу нет страниц, ее PR будет не нулевым, а

Так как есть вероятность, что пользователь мог попасть на эту страницу не с каких-то других страниц, а, скажем, из закладок.

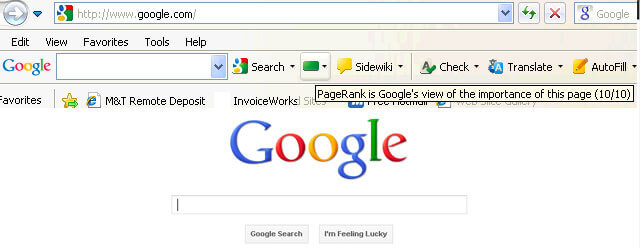

Сначала рейтинг PageRank был публично виден на панели инструментов Google, и каждая страница имела свой рейтинг от 0 до 10, скорее всего, в логарифмической шкале.

Алгоритмы ранжирования Google в те времена были очень простыми: высокий PR и плотность ключевых слов были единственными двумя вещами, которые требовались странице для высокого рейтинга в поисковой выдаче. В результате веб-страницы были переполнены ключевыми словами, а владельцы веб-сайтов начали манипулировать PageRank, искусственно увеличивая спам-обратные ссылки. Это было легко сделать: ссылочные фермы и продажа ссылок служили владельцам веб-сайтов «рукой помощи».

Google решил дать отпор ссылочному спаму. В 2003 году Google оштрафовал веб-сайт рекламной сети SearchKing за манипулирование ссылками. SearchKing подала в суд на Google, но Google выиграла. Таким способом Google пытался ограничить всех от манипулирования ссылками, однако это ни к чему не привело. Линк-фермы просто ушли в подполье, а их количество сильно возросло.

Кроме того, увеличилось количество спам-комментариев в блогах. Боты атаковали комментарии любого, скажем, блога WordPress и оставляли огромное количество комментариев типа «нажми сюда, чтобы купить волшебные таблетки». Чтобы предотвратить спам и пиар-манипуляции в комментариях, Google ввел тег nofollow в 2005 году. И снова то, что Google хотел стать успешным шагом в войне манипулирования ссылками, было реализовано извращенным образом. Люди начали использовать теги nofollow для искусственного перенаправления PageRank на нужные им страницы. Эта тактика стала известна как скульптурирование PageRank.

Чтобы предотвратить пиар-лепку, Google изменил способ распределения PageRank. Раньше, если на странице были ссылки nofollow и dofollow, весь объем PR страницы передавался на другие страницы, на которые ссылаются ссылки dofollow. В 2009 году Google начал делить PR страницы поровну между всеми ссылками, которые были на странице, но передавал только те доли, которые были отданы ссылкам dofollow.

Покончив с моделированием PageRank, Google не остановил войну ссылочного спама и, как следствие, начал скрывать рейтинг PageRank от глаз общественности. Во-первых, Google запустил новый браузер Chrome без панели инструментов Google, на которой отображался рейтинг PR. Затем они перестали сообщать о рейтинге PR в Google Search Console. Затем браузер Firefox перестал поддерживать панель инструментов Google. В 2013 году PageRank был в последний раз обновлен для Internet Explorer, а в 2016 году Google официально закрыл панель инструментов для публичного доступа.

Еще одним способом, который Google использовал для борьбы со схемами ссылок, было обновление Penguin, которое понижало рейтинг веб-сайтов с подозрительными профилями обратных ссылок. Выпущенный в 2012 году, Penguin не стал частью алгоритма реального времени Google, а скорее представлял собой «фильтр», время от времени обновляемый и повторно применяемый к результатам поиска. Если веб-сайт подвергался наказанию со стороны Penguin, оптимизаторам приходилось тщательно проверять свои ссылочные профили и удалять токсичные ссылки или добавлять их в список отклонения (функция, появившаяся в те дни, чтобы сообщать Google, какие входящие ссылки следует игнорировать при расчете PageRank). После аудита ссылочных профилей таким образом оптимизаторам пришлось ждать около полугода, пока алгоритм Penguin не пересчитает данные.

В 2016 году Google включил Penguin в свой основной алгоритм ранжирования. С тех пор он работает в режиме реального времени, алгоритмически борясь со спамом гораздо успешнее.

В то же время Google работал над обеспечением качества, а не количества ссылок, закрепив это в своих рекомендациях по качеству схем ссылок.

Что ж, мы закончили с прошлым PageRank. Что сейчас происходит?

Еще в 2019 году бывший сотрудник Google сказал, что первоначальный алгоритм PageRank не использовался с 2006 года и был заменен другим, менее ресурсоемким алгоритмом, когда Интернет стал больше. Что вполне может быть правдой, поскольку в 2006 году Google подала новый патент на создание рейтинга страниц с использованием расстояний в графе веб-ссылок.

Да, это. Это уже не тот PageRank, который был в начале 2000-х годов, но Google продолжает сильно полагаться на авторитетность ссылок. Например, бывший сотрудник Google Andrey Lipattsev упомянул об этом в 2016 году. В ходе видеовстречи Google Q&A пользователь спросил его, какие основные сигналы ранжирования использует Google. Ответ Andrey был вполне однозначным.

Я могу сказать вам, что они собой представляют. Это контент и ссылки, указывающие на ваш сайт.

В 2020 году John Mueller еще раз это подтвердил:

Да, мы используем PageRank внутри себя, среди многих других сигналов. Это не совсем то же самое, что оригинальная статья, в ней много особенностей (например, дезавуированные ссылки, игнорируемые ссылки и т. д.), и, опять же, мы используем множество других сигналов, которые могут быть гораздо более сильными.

Как видите, PageRank все еще жив и активно используется Google при ранжировании страниц в сети.

Что интересно, сотрудники Google продолжают напоминать нам, что существует много, много, МНОГО других факторов ранжирования Google. Но мы смотрим на это с недоверием. Учитывая, сколько усилий Google потратил на борьбу со ссылочным спамом, в интересах Google было бы переключить внимание оптимизаторов с уязвимых к манипуляциям факторов (такими как обратные ссылки) и направить это внимание на что-то невинное и приятное. Но поскольку SEO-специалисты хорошо умеют читать между строк, они продолжают считать PageRank сильным сигналом ранжирования и увеличивают обратные ссылки всеми возможными способами. Они по-прежнему используют PBN, практикуют многоуровневое построение ссылок, покупают ссылки и так далее, как это было очень давно. Вместе с рейтингом PageRank будет жить и ссылочный спам. Мы не рекомендуем ничего из этого, но такова реальность SEO, и мы должны это понимать.

Итак, вы поняли, что PageRank сейчас не тот PageRank, который был 20 лет назад.

Одной из ключевых модернизаций PR стал переход от кратко упомянутой выше модели Random Surfer к модели Reasonable Surfer в 2012 году. Reasonable Surfer предполагает, что пользователи не ведут себя хаотично на странице, а кликают только по тем ссылкам, которые им интересны. момент. Скажем, читая статью в блоге, вы с большей вероятностью нажмете ссылку в содержании статьи, а не ссылку «Условия использования» в нижнем колонтитуле.

Кроме того, Reasonable Surfer потенциально может использовать множество других факторов при оценке привлекательности ссылки. Все эти факторы были тщательно рассмотрены Bill Slawski в его статье, но я бы хотел сосредоточиться на двух факторах, которые оптимизаторы обсуждают чаще всего. Это позиция ссылки и посещаемость страницы. Что мы можем сказать об этих факторах?

Ссылка может располагаться где угодно на странице — в ее содержании, меню навигации, биографии автора, подвале и вообще в любом структурном элементе, который содержит страница. А разное расположение ссылок влияет на ценность ссылки. John Mueller подтвердил это, заявив, что ссылки, размещенные внутри основного контента, весят больше, чем все остальные:

Это область страницы, где находится основной контент, контент, о котором на самом деле идет эта страница, а не меню, боковая панель, нижний колонтитул, заголовок… Тогда это то, что мы принимаем во внимание и стараемся использовать эти ссылки.

Таким образом, считается, что ссылки в нижнем колонтитуле и навигационные ссылки передают меньший вес. И этот факт время от времени подтверждается не только представителями Google, но и реальными случаями.

В недавнем случае, представленном Мартином Хейманом на BrightonSEO, Мартин добавил ссылку, которая уже была у него в навигационном меню, к основному содержимому страниц. В результате на этих страницах категорий и страницах, на которые они ссылаются, трафик увеличился на 25%.

Этот эксперимент доказывает, что ссылки на контент имеют больший вес, чем любые другие.

Что касается ссылок в биографии автора, оптимизаторы предполагают, что био-ссылки что-то весят, но менее ценны, чем, скажем, ссылки на контент. Хотя у нас нет особых доказательств, кроме того, что сказал Matt Cutts, когда Google активно боролся с чрезмерным количеством гостевых блогов за обратные ссылки.

John Mueller разъяснил, как Google обрабатывает трафик и поведение пользователей с точки зрения передачи ссылочного веса в одной из видеовстреч в Search Console Central. Пользователь спросил Мюллера, учитывает ли Google вероятность кликов и количество кликов по ссылке при оценке качества ссылки. Ключевые выводы из ответа Мюллера заключались в следующем:

Google не учитывает клики по ссылкам и вероятность кликов при оценке качества ссылки.

Google понимает, что ссылки часто добавляются к контенту, например, отсылкам, и от пользователей не требуется, чтобы они нажимали на каждую ссылку, с которой они сталкиваются.

Тем не менее, как всегда, оптимизаторы сомневаются, стоит ли слепо верить всему, что говорит Google, и продолжают экспериментировать. Итак, ребята из Ahrefs провели исследование, чтобы проверить, связана ли позиция страницы в поисковой выдаче с количеством обратных ссылок со страниц с высоким трафиком. Исследование показало, что корреляции практически нет. Более того, на некоторых страницах с самым высоким рейтингом вообще не было обратных ссылок со страниц с высоким трафиком.

Это исследование указывает нам на то же направление, что и слова John Mueller: вам не обязательно создавать обратные ссылки на свою страницу, генерирующие трафик, чтобы получить высокие позиции в поисковой выдаче. С другой стороны, дополнительный трафик никогда не причинял вреда ни одному веб-сайту. Единственное сообщение здесь заключается в том, что обратные ссылки с большим трафиком, похоже, не влияют на рейтинг Google.

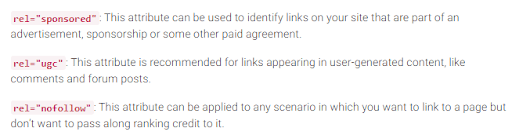

Как вы помните, Google представил тег nofollow в 2005 году как способ борьбы со ссылочным спамом. Что-то изменилось сегодня? На самом деле да.

Во-первых, Google недавно представил еще два типа атрибута nofollow. До этого Google предлагал пометить все обратные ссылки, которые вы не хотите принимать в расчете PageRank, как nofollow, будь то комментарии в блогах или платная реклама. Сегодня Google рекомендует использовать rel="sponsored" для платных и партнерских ссылок и rel="ugc" для пользовательского контента.

Интересно, что эти новые теги не являются обязательными (по крайней мере, пока), и Google отмечает, что вам не нужно вручную менять все rel=”nofollow” на rel="sponsored" и rel=”ugc”. Эти два новых атрибута теперь работают так же, как обычный тег nofollow.

Во-вторых, Google теперь заявляет, что теги nofollow, а также новые теги, спонсируемые и ugc, рассматриваются как подсказки, а не директивы при индексировании страниц.

Помимо входящих ссылок, существуют еще исходящие, то есть ссылки, ведущие на другие страницы с вашей.

Многие SEO-специалисты считают, что исходящие ссылки могут повлиять на рейтинг, однако это предположение считается SEO-мифом. Но есть одно интересное исследование, на которое стоит обратить внимание в этом отношении.

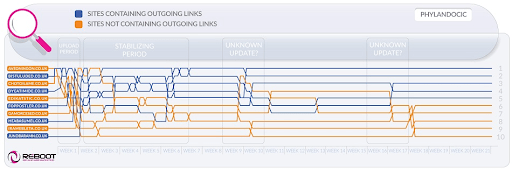

Reboot Online провела эксперимент в 2015 году и повторила его в 2020 году. Они хотели выяснить, влияет ли наличие исходящих ссылок на высокоавторитетные страницы на позиции страницы в поисковой выдаче. Они создали 10 веб-сайтов со статьями по 300 слов, оптимизированных под несуществующее ключевое слово — Phylandocic. 5 сайтов остались вообще без исходящих ссылок, а 5 сайтов содержали исходящие ссылки на авторитетные ресурсы. В результате сайты с авторитетными исходящими ссылками стали занимать самые высокие места в рейтинге, а те, у которых ссылок вообще не было, заняли самые низкие позиции.

С одной стороны, результаты этого исследования могут сказать нам, что исходящие ссылки действительно влияют на позиции страниц. С другой стороны, поисковый запрос в исследовании совершенно новый, а содержание веб-сайтов посвящено медицине и лекарствам. Таким образом, высока вероятность того, что запрос был классифицирован как YMYL. И Google много раз заявлял о важности EAT для веб-сайтов YMYL. Таким образом, исходящие ссылки вполне можно рассматривать как сигнал EAT, доказывающий, что страницы содержат фактически точный контент.

Что касается обычных запросов (не YMYL), John Mueller много раз говорил, что вам не нужно бояться ссылаться на внешние источники вашего контента, поскольку исходящие ссылки полезны для ваших пользователей.

Кроме того, исходящие ссылки могут быть полезны и для SEO, поскольку они могут учитываться искусственным интеллектом Google при фильтрации Интернета от спама. Потому что на спам-страницах обычно мало исходящих ссылок, если они вообще есть. Они либо ссылаются на страницы того же домена (если они когда-нибудь задумываются о SEO), либо содержат только платные ссылки. Итак, если вы ссылаетесь на некоторые заслуживающие доверия ресурсы, вы как бы показываете Google, что ваша страница не является спамовой.

Когда-то существовало мнение, что Google может вручную наказать вас за слишком большое количество исходящих ссылок, но John Mueller сказал, что это возможно только в том случае, если исходящие ссылки явно являются частью какой-то схемы обмена ссылками, плюс веб-сайт в целом низкое качество. Что Google имеет в виду под очевидным, на самом деле является загадкой, поэтому имейте в виду здравый смысл, высококачественный контент и базовое SEO.

Пока существует PageRank, оптимизаторы будут искать новые способы манипулировать им.

Еще в 2012 году Google чаще применял ручные меры для манипулирования ссылками и спама. Но теперь, благодаря своим хорошо обученным алгоритмам защиты от спама, Google может просто игнорировать определенные спам-ссылки при расчете PageRank, а не понижать рейтинг всего сайта в целом. Как сказал John Mueller:

Случайные ссылки, собранные на протяжении многих лет, не обязательно вредны, мы тоже наблюдаем их уже давно и можем игнорировать все эти странные фрагменты веб-граффити, сделанные давным-давно.

Это также верно и в отношении негативного SEO, когда ваш профиль обратных ссылок скомпрометирован вашими конкурентами:

В общем, мы автоматически принимаем это во внимание и пытаемся… автоматически игнорировать их, когда видим, что они происходят. По большей части, я подозреваю, что это работает довольно хорошо. Я вижу очень мало людей, у которых есть реальные проблемы по этому поводу. Так что я думаю, что в основном это работает хорошо. Что касается дезавуирования этих ссылок, я подозреваю, что если это обычные спам-ссылки, которые просто появляются на вашем веб-сайте, то я бы не стал слишком беспокоиться о них. Наверное, мы сами это поняли.

Однако это не значит, что вам не о чем беспокоиться. Если обратные ссылки вашего сайта игнорируются слишком часто и слишком часто, у вас все равно есть высокий шанс получить ручное действие. Как говорит Marie Haynes в своем совете по управлению ссылками в 2021 году:

Ручные действия зарезервированы для случаев, когда на приличном в остальном сайте есть неестественные ссылки, указывающие на него, в настолько большом масштабе, что алгоритмам Google неудобно их игнорировать.

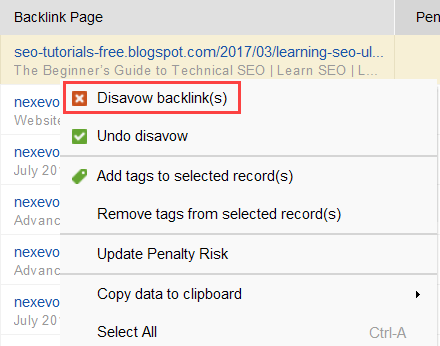

Чтобы попытаться выяснить, какие ссылки вызывают проблему, прочитайте это руководство о том, как проверить качество обратных ссылок. Короче говоря, вы можете использовать средство проверки обратных ссылок, такое как SEO SpyGlass. В инструменте перейдите в раздел «Профиль обратных ссылок» > «Штрафовой риск». Обратите внимание на обратные ссылки с высоким и средним риском.

Скачать SEO SpyGlassЧтобы дополнительно выяснить, почему та или иная ссылка считается вредоносной, щелкните знак i в столбце «Риск штрафа». Здесь вы увидите, почему инструмент посчитал ссылку плохой, и решите, дезавуировать ссылку или нет.

Скачать SEO SpyGlassЕсли вы решите отклонить ссылку из группы ссылок, щелкните ее правой кнопкой мыши и выберите опцию «Отклонить обратные ссылки»:

После того, как вы сформировали список ссылок для исключения, вы можете экспортировать файл отклонения из SEO SpyGlass и отправить его в Google через GSC.

Говоря о PageRank, нельзя не упомянуть внутреннюю перелинковку. Входящий PageRank — это вещь, которую мы не можем контролировать, но мы можем полностью контролировать то, как PR распространяется на страницах нашего сайта.

Google также много раз заявлял о важности внутренних ссылок. John Mueller еще раз подчеркнул это на одной из последних встреч в Search Console Central. Пользователь спросил, как сделать некоторые веб-страницы более мощными. А John Mueller сказал следующее:

...Вы можете помочь с внутренними ссылками. Таким образом, на вашем веб-сайте вы действительно можете выделить страницы, которые вы хотите выделить больше, и убедиться, что они действительно хорошо связаны внутри. И, возможно, страницы, которые вы не считаете важными, убедитесь, что они имеют немного меньше внутренних ссылок.

Внутренние ссылки значат очень много. Это помогает вам распределять входящий PageRank между различными страницами вашего веб-сайта, тем самым укрепляя неэффективные страницы и делая ваш сайт сильнее в целом.

Что касается подходов к внутренним ссылкам, у оптимизаторов есть много разных теорий. Один из популярных подходов связан с глубиной кликов по веб-сайту. Эта идея гласит, что все страницы вашего веб-сайта должны находиться на расстоянии не более трех кликов от главной страницы. Хотя Google также много раз подчеркивал важность мелкой структуры веб-сайтов, на самом деле это кажется недостижимым для всех больших веб-сайтов.

Еще один подход основан на концепции централизованных и децентрализованных внутренних ссылок. Как описывает это Kevin Indig:

Централизованные сайты имеют единый пользовательский поток и воронку, которая ведет на одну ключевую страницу. Сайты с децентрализованными внутренними ссылками имеют несколько точек конверсии или разные форматы регистрации.

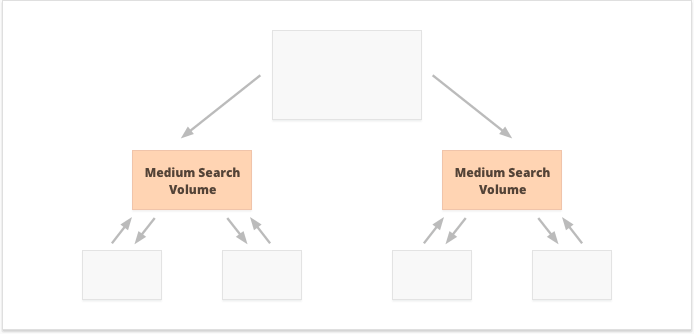

В случае централизованной внутренней перелинковки у нас есть небольшая группа страниц конверсии или одна страница, и мы хотим, чтобы она была мощной. Если мы применяем децентрализованные внутренние ссылки, мы хотим, чтобы все страницы веб-сайта были одинаково мощными и имели одинаковый PageRank, чтобы все они ранжировались по вашим запросам.

Какой вариант лучше? Все зависит от особенностей вашего сайта и бизнес-ниши, а также от ключевых слов, на которые вы собираетесь ориентироваться. Например, централизованная внутренняя перелинковка лучше подходит для ключевых слов с высоким и средним объемом поиска, поскольку в результате получается узкий набор сверхмощных страниц.

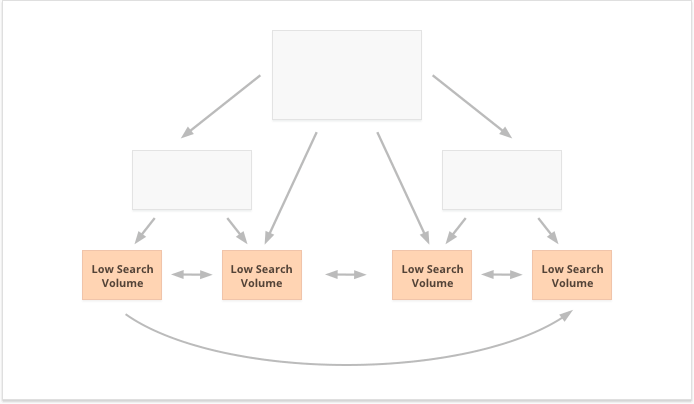

Ключевые слова с длинным хвостом и небольшим объемом поиска, наоборот, лучше подходят для децентрализованной внутренней перелинковки, поскольку они равномерно распределяют PR среди многочисленных страниц сайта.

Еще один аспект успешной внутренней перелинковки — баланс входящих и исходящих ссылок на странице. В связи с этим многие оптимизаторы используют CheiRank (CR), который на самом деле является обратным PageRank. Но в то время как PageRank — это полученная мощность, CheiRank — это отдаваемая мощность ссылки. После того, как вы рассчитаете PR и CR для своих страниц, вы сможете увидеть, на каких страницах есть аномалии ссылок, то есть случаи, когда страница получает большой PageRank, но немного проходит дальше, и наоборот.

Интересный эксперимент Kevin Indig — сглаживание аномалий ссылок. Простое обеспечение баланса входящего и исходящего PageRank на каждой странице веб-сайта принесло очень впечатляющие результаты. Красная стрелка здесь указывает на момент устранения аномалий:

Аномалии ссылок — не единственное, что может нанести ущерб PageRank. Убедитесь, что у вас нет технических проблем, которые могут разрушить ваш с трудом заработанный пиар:

Страницы-сироты. Страницы-сироты не связаны ни с одной другой страницей вашего веб-сайта, поэтому они просто простаивают и не получают никакой ссылочной массы. Google не видит их и не знает, что они действительно существуют.

Цепочки перенаправления. Хотя Google утверждает, что редиректы теперь проходят 100% PR, все равно рекомендуется избегать длинных цепочек редиректов. Во-первых, они в любом случае съедают ваш краулинговый бюджет. Во-вторых, мы знаем, что не можем слепо верить всему, что говорит Google.

Ссылки в неразбираемом JavaScript. Поскольку Google не может их прочитать, они не будут передавать PageRank.

404 ссылки. Ссылки 404 ведут в никуда, поэтому PageRank тоже никуда не денется.

Ссылки на неважные страницы. Конечно, вы не можете оставить ни одну из своих страниц вообще без ссылок, но страницы не созданы равными. Если какая-то страница менее важна, нерационально прикладывать слишком много усилий для оптимизации ссылочного профиля этой страницы.

Слишком далекие страницы. Если страница расположена слишком глубоко на вашем сайте, скорее всего, она получит мало PR или вообще не получит его. Поскольку Google может не успеть найти и проиндексировать его.

Чтобы убедиться, что ваш веб-сайт не подвержен этим угрозам PageRank, вы можете проверить его с помощью WebSite Auditor. Этот инструмент имеет полный набор модулей в разделе «Структура сайта» > «Аудит сайта», которые позволяют вам проверить общую оптимизацию вашего веб-сайта и, конечно же, найти и исправить все проблемы, связанные со ссылками, такие как длинные перенаправления:

Скачать Website Auditorи битые ссылки:

Скачать Website AuditorЧтобы проверить свой сайт на наличие потерянных или слишком удаленных страниц, переключитесь в «Структура сайта» > «Визуализация»:

Скачать Website AuditorВ этом году PageRank исполнилось 23 года. И я думаю, он старше, чем некоторые из наших сегодняшних читателей:) Но что будет с PageRank в будущем? Неужели однажды оно полностью исчезнет?

Когда я пытаюсь представить себе популярную поисковую систему, не использующую обратные ссылки в своем алгоритме, единственная идея, которую я могу придумать, — это эксперимент Яндекса, проведенный еще в 2014 году. Поисковая система объявила, что исключение обратных ссылок из их алгоритма может, наконец, остановить ссылочных спамеров от манипуляций и помочь направить их усилия на создание качественного веб-сайта.

Возможно, это была настоящая попытка перейти к альтернативным факторам ранжирования или просто попытка убедить массы отказаться от ссылочного спама. Но в любом случае всего через год после объявления Яндекс подтвердил, что ссылочные факторы вернулись в их систему.

Но почему обратные ссылки так необходимы поисковым системам?

Несмотря на бесчисленное множество других точек данных для изменения результатов поиска после начала их показа (например, поведение пользователей и настройки BERT), обратные ссылки остаются одним из наиболее надежных критериев авторитетности, необходимых для формирования первоначальной результатов поиска. Единственным их конкурентом здесь, пожалуй, являются сущности.

Как сказал Bill Slawski, когда его спросили о будущем PageRank:

Google изучает машинное обучение, извлечение фактов и понимание пар ключевых значений для бизнес-субъектов, что означает движение к семантическому поиску и более эффективному использованию структурированных данных и повышению их качества.

Тем не менее, Google вряд ли откажется от того, во что вложили десятки лет в разработку.

Google очень хорош в анализе ссылок, который сейчас является очень зрелой веб-технологией. Поэтому вполне возможно, что PageRank будет продолжать использоваться для ранжирования органических результатов поиска.

Еще одна тенденция, на которую указал Bill Slawski, — это новости и другие кратковременные результаты поиска:

Google сообщил нам, что он меньше полагается на PageRank для страниц, где своевременность более важна, например, результаты в реальном времени (например, из Twitter) или результаты новостей, где своевременность очень важна.

Действительно, новостей в результатах поиска слишком мало, чтобы накопить достаточно обратных ссылок. Таким образом, Google работал и может продолжать работать над заменой обратных ссылок другими факторами ранжирования при работе с новостями.

Однако на данный момент рейтинг новостей во многом определяется авторитетностью ниши издателя, и мы по-прежнему воспринимаем авторитетность как обратные ссылки:

«Сигналы авторитетности помогают расставить приоритеты в получении высококачественной информации из наиболее надежных доступных источников. Для этого наши системы предназначены для выявления сигналов, которые могут помочь определить, какие страницы демонстрируют экспертность, авторитетность и надежность по заданной теме, на основе отзывов поисковых оценщиков. Эти сигналы могут включать в себя то, ценят ли другие люди источник похожих запросов или ссылаются ли на эту историю другие известные веб-сайты по этой теме».

И последнее, но не менее важное: я был очень удивлен усилиями Google, направленными на то, чтобы иметь возможность идентифицировать спонсируемые и созданные пользователями обратные ссылки и отличать их от других ссылок nofollow.

Если все эти обратные ссылки следует игнорировать, зачем отличать их друг от друга? Особенно учитывая, что John Mueller предполагает, что позже Google может попытаться по-другому относиться к этим типам ссылок.

Мое самое смелое предположение заключалось в том, что, возможно, Google проверяет, могут ли реклама и ссылки, созданные пользователями, стать положительным сигналом ранжирования.

Ведь реклама на популярных площадках требует огромных бюджетов, а огромные бюджеты – атрибут крупного и популярного бренда.

Пользовательский контент, если его рассматривать вне парадигмы спама в комментариях, представляет собой реальных клиентов, которые одобряют свои действия в реальной жизни.

Однако эксперты, к которым я обратился, не верили, что это возможно:

Я сомневаюсь, что Google когда-либо посчитает рекламные ссылки положительным сигналом.

Идея здесь, по-видимому, заключается в том, что, различая различные типы ссылок, Google попытается выяснить, по каким из ссылок nofollow следует переходить в целях построения сущности:

У Google нет проблем с пользовательским контентом или спонсируемым контентом на веб-сайте, однако оба они исторически использовались как методы манипулирования рейтингом страниц. Таким образом, веб-мастерам рекомендуется размещать атрибут nofollow в этих ссылках (помимо других причин для использования nofollow). Однако ссылки nofollow по-прежнему могут быть полезны Google для некоторых задач (например, для распознавания объектов), поэтому ранее они отмечали, что они вы можете рассматривать это скорее как предложение, а не как директиву, такую как правило запрета в robots.txt на вашем собственном сайте. Заявление John Mueller было таким: «Я могу представить, что в наших системах мы можем со временем научиться относиться к ним немного по-другому. ». Это может относиться к случаям, когда Google рассматривает nofollow как предложение. Гипотетически вполне возможно, что системы Google смогут узнать, по каким ссылкам nofollow следует переходить, основываясь на данных, полученных от типов ссылок, помеченных как ugc и спонсируемых. Опять же, это не должно сильно повлиять на рейтинг сайта, но теоретически может повлиять и на сайт, на который ссылаются.

Я очень надеюсь, что мне удалось прояснить роль обратных ссылок в текущих поисковых алгоритмах Google. Некоторые данные, с которыми я столкнулся при написании статьи, оказались неожиданностью даже для меня. Поэтому я с нетерпением жду возможности присоединиться к вашему обсуждению в комментариях.

Есть вопросы, которые у вас остались без ответа? Есть ли у вас идеи относительно будущего PageRank?